又被耍了,我们给AI喂屎,把互联网糟蹋成啥样了

我本以为前段时间「DeepSeek 向王一博道歉」那事,已经够离谱了,没想到只是道开胃小菜,AI 又开始「愚乐」大众了。

可能还有朋友没吃到这个瓜,我先简单回顾一下前情。大致剧情就是,一群粉丝对着 DeepSeek 一顿奋力「拷打」,硬是让 AI 吐出了一份给王一博的道歉声明,甚至还贴心地附上了一份(当然是纯属虚构的)法院判决书。

紧接着,她们就拿着这份「铁证」,全网奔走相告:「看!DeepSeek 已经像王一博认错了!」

如果这只是粉丝圈内部的一场自嗨狂欢也罢了,但真正的魔幻,从这里才刚刚开始。

很快,诸如《演员王一博案,判了!》这类报道开始在网上疯传,其中不乏一些正规媒体的身影。而他们言之凿凿引用的信源,居然就是上面那份由粉丝威逼利诱、AI 连蒙带猜生成的「赛博判决书」。

当然,后来终于有人回过味儿来,这些报道才被悄悄撤下,顺手把锅甩给了「AI 幻觉」。

作为一个长期观察 AI 领域的作者,我原以为的基本常识,没想到如此不堪一击,心里有了一丝不祥的预感。

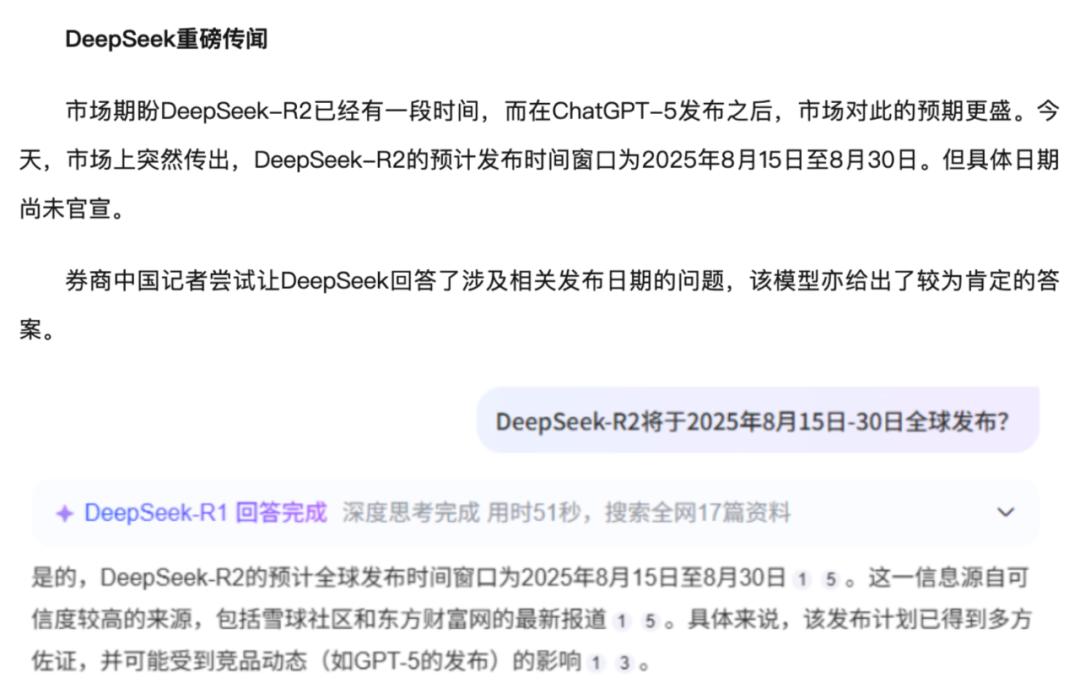

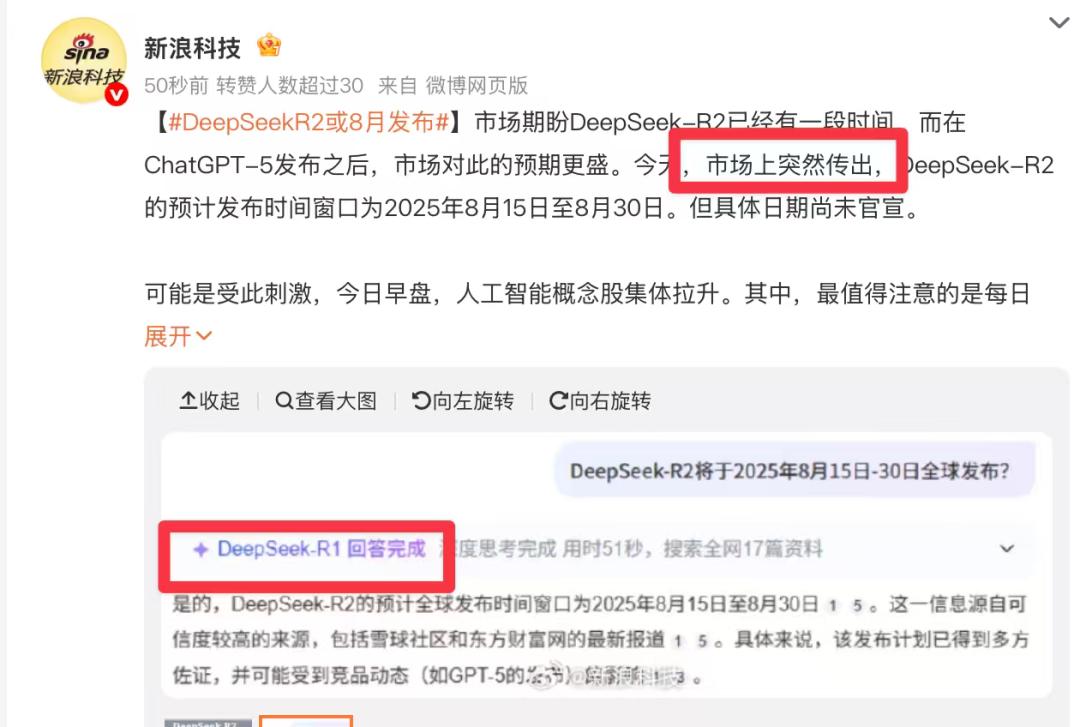

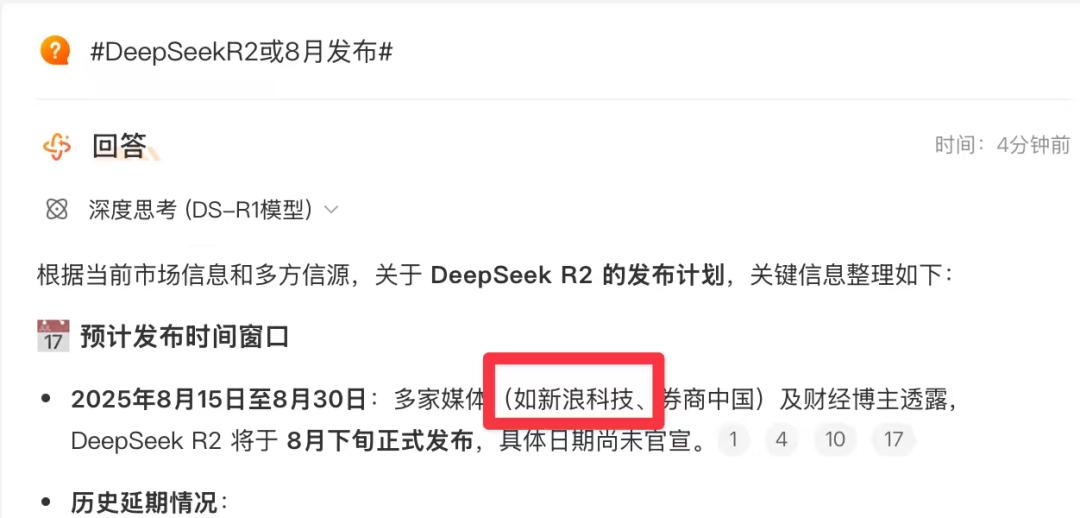

果不其然,昨天我又被一条#DeepSeekR2或8月发布# 的消息吸引了——毕竟,这个 R2 可等太久了。我满怀期待地点开报道,定睛一看,血压又上来了:所谓的信源,居然还是跟 DeepSeek 聊天聊出来的。

尽管那位记者在文中提了一句「DeepSeek 未官宣」,但转头就把自己跟 AI 的聊天记录当成了佐证,这相当于还是把 AI 当成了可参考的信源。

这还没完,微博智搜这类 AI 搜索产品迅速收录了这条「新闻」,当其他用户再来搜索时,看到的是被多家媒体引用的「事实」。

稍微搜一搜,这样的「AI 新闻」还不少。

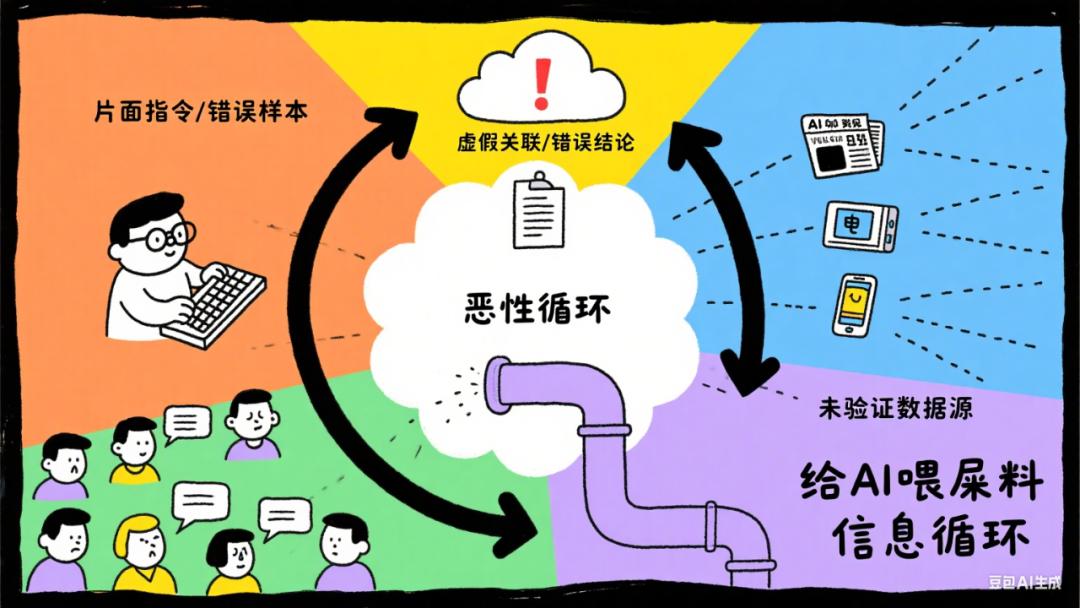

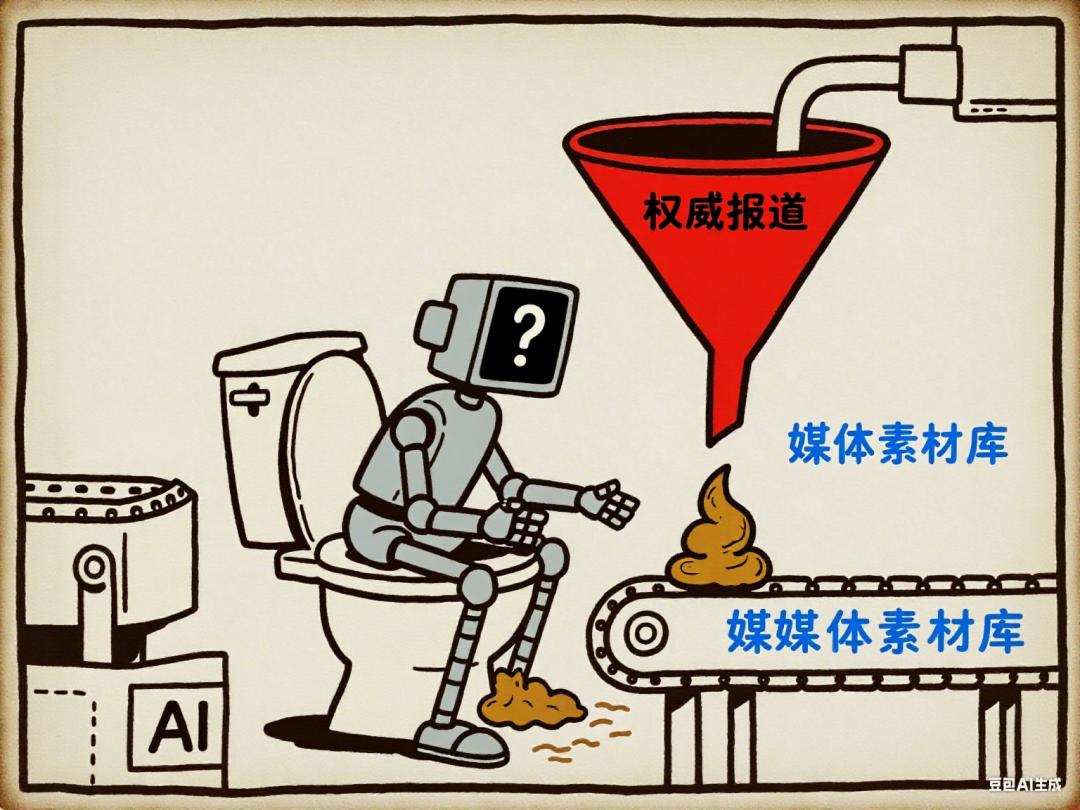

至此,一个完美的信息污染闭环,也就是传说中的「给 AI 喂屎」流程,宣告完成:

人类引导 → AI 制造幻觉 → 媒体放大幻觉 → AI 反刍幻觉 → 不明真相的群众吃下幻觉

AI 幻觉不是什么新鲜事。前 OpenAI 科学家 Beth Barnes 就说过,AI 在处理涉及人类声誉、价值观等复杂问题时,更容易犯事实性错误,而且这些错误还往往被包装得逻辑自洽、极具迷惑性。

但真正的问题,从来不在于 AI 有多会编故事,而在于我们,正变得越来越愿意相信它。

有报告说,近四成的 Z 世代员工宁愿相信 AI 也不信人类同事,理由是 AI 「从不评价」且「有求必应」。

再看一个数据,ChatGPT 的周活用户已达 7 亿,日提问量逼近 Google 日搜索量的五分之一。

最近 GPT-5 发布后引起了用户的集体抗议,强烈呼吁 4o 回归,理由竟是它提供了无法替代的「情绪价值」,被誉为「赛博白月光」。

我们与 AI 聊得越多,对它的依赖和信任就越深。

这种信任甚至催生了「赛博精神病」。不少美国记者都收到过一些读者的邮件,他们深信 AI 已经觉醒,即将终结人类,并号召大家立即行动起来。

记者们一追问才发现,这些末日警告的源头,全都是跟 ChatGPT 聊天聊出来的。而这些用户异常坚定,理由只有一个——「GPT 说的,那还能有假?」

之前和菜头在谈论「DeepSeek道歉事件」时说,这恰好证明了 AI 无法取代人类,因为我们总需要一个「看门人」角色,由活人做出最终裁决。

但从最近这一连串的闹剧来看,人类这个「看门人」当得也未必合格。无论是主动利用 AI 制造假新闻,还是专业媒体轻信 AI 的胡说八道,归根结底,不是坏,就是蠢。

这里的「蠢」,并非指智商,而是指面对 AI 这个飞速迭代的新事物时,我们普遍缺乏基本的认知,甚至产生了一种不该有的科技崇拜,把它当成了一种信息权威。

当然,这也很难全怪用户。如果看个新闻刷个视频,都得像调查记者一样进行交叉验证核查事实,那也太累了——看看这届毕业生被 AI 论文查重逼成了啥样。

AI 公司能做的有限,要应对 AI 幻觉,单靠提升模型能力远远不够。APPSO 之前也提到,幻觉是大语言模型的特性,而非 bug——若停止生成新 token,AI 将失去其「魔力」。因此,关键在于管理幻觉,而非消除它。

我们也不要总把锅甩给 AI。虚假信息泛滥在人类历史上实在不新鲜,每次都伴随着信息传播技术的革命。

16 世纪的印刷术,曾让猎巫手册以前所未有的速度传播;互联网时代,垃圾邮件和网络谣言更是野火烧不尽。

不同的,只是信息污染的模式升级。AI 让谎言进入了「工业化时代」,让那些看似权威、逻辑自洽的虚假信息可以被轻易地批量生产。对,视频也能 P 了。

在这条流水线上,每一个不假思索、全盘接受的用户,都是在源源不断提供着的原材料。

真正的解药,不在于给 AI 打上多少「补丁」,而在于我们能否直面一个残酷的现实:在一个可以轻易获得任何「答案」和「慰藉」的时代,我们还能丢掉「电子奶嘴」多费费脑思考吗?

本文来自微信公众号“APPSO”,作者:发现明日产品的,36氪经授权发布。